- - integrerte informasjonsomgivelser der programmer med mest mulig like

- - grensesnitt kan brukes til å lagre, redigere og sammenkoble alle typer

- - informasjon inklusive tekst, bilder, video, animasjon og lyd

- - samlinger av grunnlagsdata i maskinleselig form

- - referansedatasamlinger i maskinleselig form

- - bibliografisk informasjon i maskinleselig form

Espen S. Ore

PANEL: "THE HUMANITIES WORKSTATION: ENVIRONMENTS FOR TODAY AND TOMORROW"

Denne paneldiskusjonen ble holdt etter Paul Kahns foredrag. John Roper,

University of East Anglia, Norwich, venter at framtidas datamaskiner vil

kunne tilby bedre grafikk. Malcolm Brown, Stanford University, mente

at noen av de fremste egenskapene vil være et godt brukergrensesnitt

og evnen til å skyfle store mengder data. Ifølge George

P. Landow, Brown University, Providence, vil arbeidsstasjonen kunne

fungere som inngangen til et nettverk av data som vil influere forskningen

p.g.a. de enorme mengdene som vil være tilgjengelig. Dessuten vil

forholdet mellom leser og forfatter endres, slik at forestillingen om hva

som utgjør vitenskapelig forfatterskap må revideres. Det vil

dermed bli nødvendig å definere hva han betegnet som et "public

work". Samarbeid mellom forskere vil altså bli mer utbredt i framtida.

Etter Paul Kahns oppfatning vil det viktigste trekket ved framtidas

arbeidsstasjoner være en integrasjon med biblioteksfunksjoner.

ELECTRONIC TEXTS: LEGAL ASPECTS

Catherine Blackburn fra University of Oxford ga en orientering om

den britiske opphavsrett-lovgivningen og hvordan den anvendes i forbindelse

med elektroniske tekster. I Storbritannia må den som ønsker

å lage en elektronisk versjon av en tekst ha tillatelse fra den som

har opphavsretten. For å selv få opphavsrett til en elektronisk

versjon av en tekst, kreves det en viss grad av originalitet i tilretteleggingen.

STATE OF THE ART: THE DEVELOPMENT AND CATALOGUING OF ELECTRONIC TEXT

Michael Neuman, Georgetown Center for Text and Technology, Georgetown

University, Washington DC presenterte senterets arbeid med "Catalog of

Archives and Projects in Machine-Readable Texts" og den tilhørende

databasen. Hittil er det registrert 308 prosjekter i 76 språk fra

26 land. De fleste er engelskspråklige, men også land som Brasil

og Saudi-Arabia er representert. Materialet dekker fagområdene lingvistikk,

litteratur, bibelstudier og språk, og spenner over hele 5000 år

(skjønt de fleste tekster stammer fra det 20. århundre).

THE HISTORY WORKSTATION PROJECT

Manfred Thaller, Max-Planck Institut für Geschichte, Göttingen,

innledet en spesialsesjon om en gruppe med forskningsprosjekter som har

som hovedformål å utvikle edb-redskaper for historisk (og relatert)

forskning. Thaller fortalte bl.a. at prosjektmedarbeiderne har gitt opp

å prøve å standardisere koder for merking av historisk

materiale. De arbeider heller med standarder for utveksling av data.

DANIEL DEFOE: AN AUTHORSHIP ATTRIBUTION STUDY

På konferansen var det utrolig mange uinspirerte foredragsholdere

som ramset opp manusene sine ledsaget av uleselige overheads. Det var derfor

en glede å være til stede ved Joseph Rudmans klare og

engasjerende framstilling av sitt arbeid med å tilrettelegge en database

over verk som kan tilskrives Daniel Defoe.

METHODS AND APPLICATIONS: THE EXAMPLE OF FRENCH

Paul A. Fortier, University of Manitoba, Winnipeg, tok fransk litteratur

som utgangspunkt for sitt foredrag om edb-metoder og -anvendelser. Han

mente at datateknologien kommer til å endre litteraturvitenskapen

like mye som oppfinnelsene i det 18. århundre forandret studiet av

naturvitenskapene. Han var imidlertid sterkt kritisk til dagens edb-bruk

- han ser en tendens til konsentrasjon om hva datamaskinen kan utføre

enklere enn manuelle metoder. Som eksempel nevnte han produksjon av konkordanser,

som er blitt et mål i seg selv. Edb-anvendelser overskygger litteraturvitenskapelig

metodologi. Altfor mye forskning er basert kun på eksempler.

MEDIA AND COMPUTERS

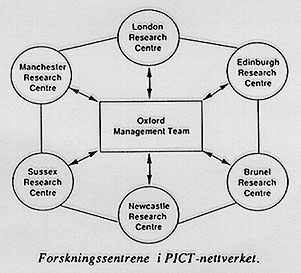

Denne sesjonen dreide seg dels om det britisk forskningsprogrammet PICT

(Programme on Information and Communications Technologies), dels om datakunst.

Kristin Natvig

AUTOMATIC GENERATION OF TEXTS WITHOUT USING COGNITIVE MODELS: TELEVISION

NEWS

Det faglig sett mest oppsiktsvekkende foredraget jeg overvar under hele

konferansen ble holdt av Ulrich Schmitz, Universität Duisburg.

Schmitz fengslet tilhørerne med resultatene av sine språklige

analyser av fjernsynsnyheter. Han har brukt tradisjonelle metoder for lingvistisk

analyse og statistikk på to måneders sendinger av en tysk "dagsrevy"

(110.000 ord), og fant at nyhetsmeldingene er bygget opp ifølge

kun 38 lingvistiske "trekk". Meldingene settes sammen av mer eller mindre

ferdige språklige enheter og kan deles inn i 14 temakategorier som

"reiser og møter" og "død, ulykke og dårlig vær".

Nyhetsspråket er så ensformig at det faktisk kan produseres

automatisk uten bruk av kompliserte kognitive AI-modeller.

DEMONSTRASJONER

WIZDOM

Demonstrasjonene på konferansen var svært dårlig organisert

- det var ofte umulig å finne ut av hvor og når de egentlig

skulle finne sted. Jeg lyktes imidlertid i å få personlig veiledning

i bruk av demo-versjonen av WIZDOM, et undervisningsprogram for

engelsk på PC, utviklet av en tysk universitetslektor sammen med

tre studenter. Pakken kombinerer tekstbehandling med leksikon-støtte

og undervisningsprogrammer. Leksikonet - VIRTEX - omfatter 7000 ordstammer

og er raskt tilgjengelig uansett hvilken oppgave brukeren til enhver tid

utfører. I tillegg til å gjenfinne enkeltord eller ord i kontekst

gis det en fullstendig morfologisk analyse av hvert ord og en oversettelse

til tysk eller spansk. VIRTEX kan også gjøre nytte av kollektive

morfologi-baserte søkefunksjoner (f.eks. "finn alle flertallssubstantiver").

Leksikonet kan utvides etter behov.

MACENGLISH

MacEnglish består av flere programmer på CD-ROM: Inform

(hverdags-konversasjon), Executive English (forretnings-konversasjon)

og Pronunciation Plus (uttale-trening). Inform er lagt opp

som et tidsskrift, hvor hvert nummer inneholder artikler om ulike aspekter

ved amerikansk kultur. I tilknytning til artiklene får studenten

høre amerikanere snakke om emnene. Det er mulig å "delta"

i konversasjonen ved å ta opp og spille tilbake sin egen stemme.

Dette foregår ved hjelp av MacEnglish Sound Center, en lydkontroll-boks

som kobles til Macintosh'en. (Denne var dessverre ikke i drift da jeg skulle

prøve ut systemet). Opplegget inkluderer også flervalgs- og

rett-eller-galt spørsmål til hver artikkel.

![]()

![]()

![]()